خروجیهای گمراهکننده ماشینهای خطاکار تصمیمگیرنده

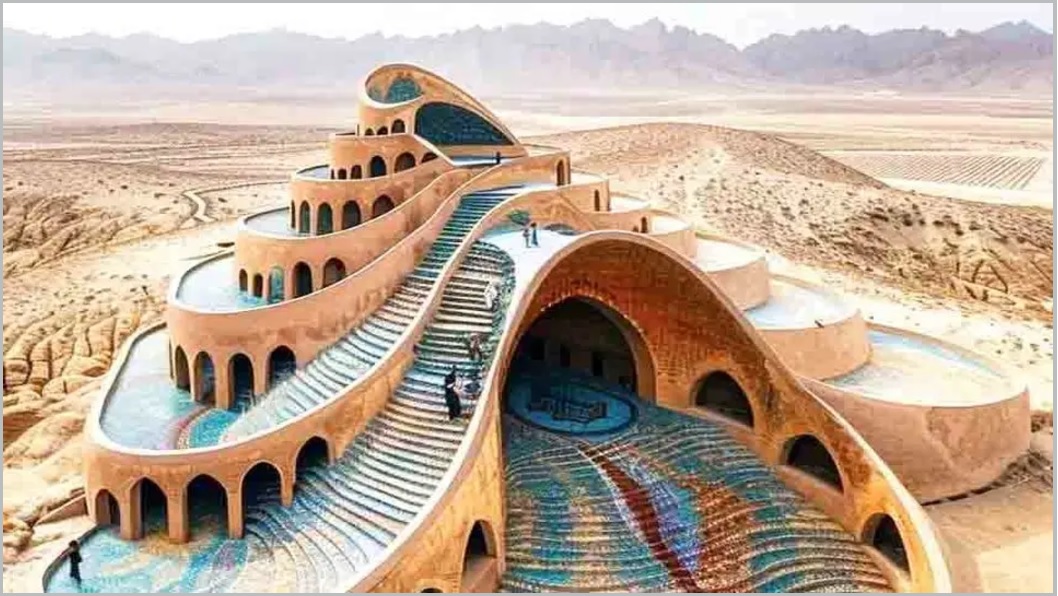

در چشمانداز بهسرعت درحال تکامل هوش مصنوعی، ما به طور مداوم مرزهای کاری را که ماشینها میتوانند انجام دهند، در پیش میگیریم؛ بااینحال، این سفر بدون چالش نیست. یکی از این موانع که توجه جمعی ما را به خود جلب کرده، پدیدهای است که به عنوان توهمات هوش مصنوعی شناخته میشود. این چالش جذاب، ترکیبی منحصربهفرد از پیچیدگی و فرصت را برای نوآوری در جامعه هوش مصنوعی ارائه میدهد. در دنیای پرشتاب فناوری، توهم اصطلاحی است که اغلب در بحث راجعبه قابلیتها و محدودیتهای مدلهای هوش مصنوعی، بهویژه مدلهای مربوط به زبان و تولید تصویر ظاهر میشود. این مفهوم، درحالیکه جذاب است، برای کسانی که با عملکرد درونی هوش مصنوعی آشنا نیستند، میتواند تا حدودی گیجکننده باشد. توهمات هوش مصنوعی زمانی اتفاق میافتد که مدلهای یادگیری ماشینی، اطلاعات نادرست یا گمراهکنندهای تولید میکنند که توسط دادههای ورودی پشتیبانی نمیشود. مشابه یک سراب در بیابان، این توهمات میتوانند فریب دهند و منجر به خروجیهایی شوند که اگرچه به طور قانعکنندهای واقعبینانه به نظر میرسند، اما اساسا نادرست یا بیمعنی هستند. این پدیده در مدلهای درگیر در پردازش زبان طبیعی (NLP) و تولید تصویر رایجتر است، جایی که تمایز بین واقعیت و ساختگی گاهی اوقات میتواند محو شود. هوش مصنوعی را به عنوان یک هنرمند تصور کنید! اما بهجای نقاشی از زندگی، گاهی اوقات از تخیل نقاشی میکشد و تصاویر یا متنهایی خلق میکند که در عین جذابیت، واقعیت را کاملا منعکس نمیکنند. این توهمات زمانی رخ میدهد که مدلهای هوش مصنوعی، علیرغم الگوریتمهای پیچیده خود، خروجیهای گمراهکننده یا کاملا ساختگی تولید میکنند؛ از چیزهای عجیبوغریب گرفته تا نگرانکننده. این اطلاعات غلط، پیامدهای مهمی دارند، بهویژه در کاربردهای حیاتی مانند تولید اخبار یا تحلیل اسناد حقوقی. ماهیت این چالش در توانایی هوش مصنوعی برای یادگیری الگوها و همبستگیها در مجموعه دادههای گسترده نهفته است. درحالیکه این گواهی بر قابلیتهای یادگیری مدل است، اما دری را برای تولید خروجیهای مبتنیبر دادههای مغرضانه، ناقص یا غیرعادی باز میکند. عواقب آن از سوءتفاهمات طنزآمیز گرفته تا اطلاعات نادرست بسیار جدی را شامل میشود که بر همهچیز، از رفتار دستیار شخصی تا یکپارچگی مقالات خبری تولیدشده توسط هوش مصنوعی، تأثیر میگذارد.

جادوی توهم

هر فناوری به اندازه کافی پیشرفته، از جادو قابل تشخیص نیست. در قرن بیستویکم که فناوریها سریعتر از همیشه درحال پیشرفت هستند -بهویژه هوش مصنوعی در تمام شکلهایش- واقعا میتوان احساس کرد که در دنیایی از جادوی توهم زندگی میکنیم. این روزها تشخیص اینکه چه چیزی واقعی است و چه چیزی نیست، خیلی سخت شده است. هوش مصنوعی با وجود تمام چیزهای باارزشی که ارائه میکند اگر به طور شفاف توسعه نیابد و با درک روشنی از خطرات احتمالی آن استفاده نشود، مملو از ریسک است. حال چگونه چنین توهمی ایجاد میشود؟ این تصور که نیروهای نامرئی در کار هستند، بازتاب مفهوم جعبه سیاه الگوریتمهای یادگیری ماشینی است که عملکرد درونی آنها قابل کشف نیست. امروزه در عصر هوش مصنوعی مولد، دیگر چه چیزی را میتوانیم باور کنیم؟ ما فعالانه در میان ورود مجموعهای از فناوریهای مخرب هستیم که نحوه انجام کار و زندگی همه ما را تغییر میدهند. این قابلیتهای عمیق و کاربردهای بالقوه میتواند بهداشت و درمان را تغییر دهد و فرصتهای جدید و چالشهای اخلاقی را به وجود آورد. در این میان، چه کاربردهای عملی واقعی که میتوانند ما را درحالحاضر نجات دهند و چه برنامههای خطرناکی که میتوانند با اطلاعات نادرست آسیب برسانند، در هر صورت جعبه پاندورا، خوب یا بد، باز شده است. مردم از این برای هر برنامه ممکنی که میتوانید تصور کنید و حتی بسیاری از آنها را تصور نمیکنید، استفاده میکنند. با وجود این، فناوری روزبهروز درحال پیشرفت است. این مدلها ویژگیهای نوظهوری را نشان میدهند از جمله پاسخ به سؤال، خلاصهسازی، ترجمه، تولید ایدهها، استدلال با نظریه ذهن که بسیار انسان را شگفتزده میکند. البته شاید آنقدرها هم عجیبوغریب نباشد. خب، همه افکار ذهنی و عاطفی که عمیقا به آن توجه میکنید، به واسطه چه چیزی هست، چگونه آن را بیان میکنید و چگونه ارتباط میگیرید؟ بیشک از طریق زبان و به واسطه کلمات. بنابراین شاید عجیب نیست که اگر شما کامپیوتری دارید که در دستکاری کلمات بسیار سریع است و میتواند توهم بسیار قانعکنندهای از هوش ایجاد کند. بله، توهم اصطلاح رایجی است. این درواقع یک اصطلاح واقعا دقیق پزشکی در اینجا نیست؛ زیرا توهم به کسی اشاره دارد که چیزی را باور دارد که درست نیست. اما آنها چیزی را باور نمیکنند. آنها فکر نمیکنند. آنها نمیدانند. آنها نمیفهمند. کاری که آنها انجام میدهند این است که کلمات را در یک توالی بسیار باورپذیر به هم میچسبانند، حتی اگر هیچ معنایی وجود نداشته باشد. این توصیف کامل از همبستگی است. بااینحال، روشن است که ما درحال نزدیکشدن به نقطهای از تاریخ هستیم که در آن بین محتوای تولیدشده توسط انسان در مقابل کامپیوتر و بین اطلاعات واقعی در مقابل اطلاعات ساختگی، دیگر نمیتوان تفاوت را تشخیص داد. علاوهبراین، فناوری ممکن است واقعا همدلانهتر شود؛ یا البته در اینکه به نظر میرسد، بسیار بهتر شود. امیدوارم رایانهها و سیستمهای هوش مصنوعی به تصدی برخی از کارها کمک کنند تا بتوانیم کمی لذت را به کارمان برگردانیم. همچنان که بحث جایگزینی هوش مصنوعی با مشاغل مختلف داغ است، به نظر من کسانی که یاد میگیرند چگونه از هوش مصنوعی استفاده کنند، ممکن است جایگزین کسانی شوند که این کار را نمیکنند.

چرا توهمات هوش مصنوعی رخ میدهد؟

مدلهای هوش مصنوعی، بهویژه آنهایی که مبتنیبر یادگیری عمیق هستند، از حجم وسیعی از دادهها یاد میگیرند. آنها الگوها را شناسایی میکنند، اتصال ایجاد میکنند و براساس ورودیهایی که دریافت میکنند، خروجی تولید میکنند. بااینحال، این مدلها محتوا را به معنای انسانی «درک» نمیکنند. آنها از طریق استنتاج آماری عمل میکنند. دلایل فنی زیادی برای توهم در مدلهای زبانی بزرگ وجود دارد. درحالیکه عملکرد درونی مدلها و مکانیسمهای دقیقی که منجر به نتایج میشود مبهم است، محققان به برخی از آنها اشاره میکنند که عبارتاند از:

کیفیت داده: توهم ناشی از دادهها زمانی رخ میدهد که محتوای منبع، حاوی اطلاعات بدی باشد. مدلها بر حجم زیادی از دادههای آموزشی متکی هستند که ممکن است حاوی نویز، خطا، سوگیری یا ناسازگاری باشد.

روش تولید: توهمات میتواند از روشهای آموزش و تولید ناشی شود حتی اگر مجموعه داده، سازگار و قابل اعتماد باشد. برای مثال، سوگیری از نسلهای قبلی مدل میتواند باعث ایجاد توهم شود. رمزگشایی نادرست توسط ترانسفورماتور نیز میتواند علت توهم باشد. مدلها همچنین میتوانند ترجیحی برای کلمات عمومی یا خاص داشته باشند که بر اطلاعاتی که آنها میسازند تأثیر میگذارد.

زمینه ورودی: اگر درخواست نامشخص، متناقض باشد، ممکن است توهم رخ دهد. درحالیکه کیفیت داده و آموزش از دست کاربر خارج است، زمینه ورودی اینطور نیست. کاربر میتواند ورودیهای خود را برای بهبود نتایج تغییر دهد. مشکل اساسی توهمات هوش مصنوعی این است که اعتماد کاربران را به طور قابل توجهی مختل میکند. هرچه هوش مصنوعی برای کاربر واقعیتر شود، اعتماد آنها به آن بیشتر میشود و از خیانت به این اعتماد شگفتزده میشوند. چالشی که در توصیف این خروجیها به عنوان توهم وجود دارد، این است که از انسانگرایی استقبال میکند. توصیف یک خروجی نادرست از یک مدل زبانی به عنوان یک توهم، از برخی جهات فناوری هوش مصنوعی بیجان را انسانی میکند. سیستمهای هوش مصنوعی، علیرغم عملکردشان، آگاه نیستند. آنها هیچ تصوری از جهان خود ندارند. خروجی آنها ادراک کاربر را دستکاری میکند و میتواند به عنوان یک سراب توصیف شود، نه توهم ماشینی. چالش دیگر در مورد توهم، تازگی این پدیده و به طور کلی مدلهای زبانی بزرگ است. توهمات و کلا خروجی طوری طراحی شدهاند که روان و قابل قبول باشد. اگر کسی آمادگی خواندن خروجی را با چشمی شکاک نداشته باشد، ممکن است توهمات را باور کند. توهمات به دلیل توانایی آنها در فریبدادن افراد میتواند خطرناک باشد. آنها میتوانند ناخواسته اطلاعات نادرست منتشر کنند، نقل قولها و منابع را جعل کنند و حتی به عنوان سلاحی در حملات سایبری مورد استفاده قرار گیرند. چالش بعدی در مهار توهمات این است که مدلهای زبانی اغلب جعبه سیاه هوش مصنوعی هستند. ممکن است تعیین اینکه چرا مدل توهم خاص را ایجاد کرده، دشوار یا در بسیاری موارد غیرممکن باشد. راههای محدودی برای اصلاح مدلهای زبانی وجود دارد که چنین توهمهایی ایجاد میکنند؛ زیرا آموزش آنها در یک نقطه مشخص متوقف میشود. ورود به مدل برای تغییر دادههای آموزشی میتواند هزینه زیادی را صرف کند. زیرساخت هوش مصنوعی عموما گران است و اغلب برعهده کاربر است که مراقب توهمات باشد، نه صاحب مدل.

کاوش در راهحلها

پرداختن به توهمات هوش مصنوعی نیازمند رویکردی چندوجهی است که پیشرفتهای فناوری را با استانداردهای اخلاقی دقیق ترکیب میکند. در اینجا به بررسی آن میپردازیم:

کیفیت دادههای پیشرفته: اساس هر سیستم هوش مصنوعی قوی، در کیفیت دادههایی است که روی آن آموزش دیده است. مجموعه دادههای متنوع، دقیق و گویا برای جلوگیری از توهمات هوش مصنوعی حیاتی هستند. مجموعه دادههای متنوع تضمین میکند که هوش مصنوعی در معرض طیف گستردهای از سناریوها و متغیرها قرار میگیرد و سوگیری را کاهش میدهد و توانایی آن را برای مدیریت موقعیتهای مختلف بهبود میبخشد. دقت در دادهها از انتشار خطاها و اطلاعات نادرست از طریق خروجیهای هوش مصنوعی جلوگیری میکند. مجموعه دادههای گویا تضمین میکنند که هوش مصنوعی میتواند در موقعیتهای جمعیتی و موقعیتهای مختلف بهخوبی عمل کند و آن را در سطح جهانی قابل اجراتر میکند. این جنبههای کیفیت داده، با هم سنگری را دربرابر ایجاد خروجیهای هوش مصنوعی گمراهکننده تشکیل میدهند؛ زیرا یادگیری هوش مصنوعی را در واقعیت لنگر میاندازند و طیف وسیعی از تنوع دنیای واقعی را پوشش میدهند.

شفافیت مدل: شفافیت در مدلهای هوش مصنوعی به توانایی مدل در ارائه توضیحات قابل فهم برای تصمیمات و خروجیهای آن مربوط میشود. وقتی مدلها شفاف هستند، توسعهدهندگان و کاربران میتوانند نحوه تصمیمگیری را ردیابی کنند و تشخیص اینکه چه زمانی یک هوش مصنوعی احتمالا توهم ایجاد میکند یا ایجاد کرده است را آسانتر میکند. این شفافیت، هم برای اعتماد و هم برای پاسخگویی بسیار مهم است و امکان شناسایی سوگیریها یا اشتباهات در فرایند تصمیمگیری را فراهم میکند. توسعه چنین مدلهایی اغلب شامل ترکیب تکنیکهایی مانند هوش مصنوعی قابل توضیح (XAI) است که به دنبال بازکردن جعبه سیاه هوش مصنوعی است و بینشهایی درباره عملکرد مدل و منطق پشت نتیجهگیریهای آن ارائه میکند.

نظارت و بهروزرسانیهای منظم: مدلهای هوش مصنوعی سیستمهای تنظیم و فراموشکردن نیستند. آنها نیاز به هوشیاری مداوم دارند. نظارت مستمر بر خروجیهای هوش مصنوعی امکان تشخیص زودهنگام هرگونه ناهنجاری یا توهم را فراهم میکند. بهروزرسانیهای منظم مدل، شامل دادهها، بازخوردها و اصلاحات جدید، تضمین میکند که هوش مصنوعی مطابق با اطلاعات و زمینههای درحال ظهور تکامل مییابد. این فرایند نهتنها مسئله توهمات را کاهش میدهد، بلکه عملکرد کلی و ارتباط سیستم هوش مصنوعی را در طول زمان افزایش میدهد. چنین تعمیر و نگهداری تضمین میکند که هوش مصنوعی با روند دادههای فعلی، هنجارهای اجتماعی و انتظارات کاربر همسو میماند و با تغییراتی که در غیر این صورت میتواند منجر به عدم دقت شود، سازگار میشود.

شیوههای هوش مصنوعی: تعهد به هوش مصنوعی اخلاقی شامل ترکیب عمدی اصولی است که انصاف، مسئولیتپذیری و شفافیت را در سیستمهای هوش مصنوعی تضمین میکند. با تنظیم و پیروی از دستورالعملهای اخلاقی، توسعهدهندگان میتوانند اطمینان حاصل کنند که مدلهای هوش مصنوعی با آگاهی دقیق از تأثیر اجتماعی آنها، مسئولانه استفاده میشوند. این شامل اقداماتی برای جلوگیری از تبعیض، محافظت از حریم خصوصی و تضمین امنیت سیستمهای هوش مصنوعی است. دستورالعملهای اخلاقی همچنین دقت و یکپارچگی اطلاعات تولیدشده توسط هوش مصنوعی را الزامی میکند و مستقیما به موضوع توهمات با اولویتدادن به صداقت و قابلیت اطمینان خروجیها میپردازد. در اصل، شیوههای هوش مصنوعی اخلاقی، چارچوبی را ایجاد میکند که در آن هوش مصنوعی میتواند برای منافع بیشتر توسعه یافته و به کار گرفته شود و اطمینان حاصل شود که پیشرفتهای هوش مصنوعی به جامعه کمک میکند. این استراتژیها با هم یک رویکرد جامع را برای رسیدگی و کاهش توهمات هوش مصنوعی و حصول اطمینان از توسعه سیستمهای هوش مصنوعی قابل اعتمادتر، موثقتر و اخلاقیتر تشکیل میدهند.

سخن پایانی

توهمات هوش مصنوعی برای ما انسانها یک چالش پیچیده در زمینه هوش مصنوعی نوظهور و بهسرعت درحال گسترش است. آنها دشواری توسعه مدلهای هوش مصنوعی مولد را به ما نشان میدهند تا بتوانند به طور قابل اعتماد بین اطلاعات واقعی و اختراعی تمایز قائل شوند. توهمات هوش مصنوعی دلایل مختلفی دارد که چالشهای جدیدی را با خود به ارمغان میآورد و راهحلهای جدیدی را میطلبد. با آمادهسازی دقیق دادهها، بهبود فرایندهای آموزشی و توسعه الگوریتمهای کارآمد، مدلهای هوش مصنوعی بهتر میتوانند برای مقابله با توهمات آماده شوند. تلفیق نظارت انسانی و کنترل کیفیت از طریق آزمایش حسابرسی منظم نیز برای اطمینان از دقت و قابلیت اعتماد مدلهای هوش مصنوعی و همچنین در نظر گرفتن بازخورد و ورودی کاربر، بسیار مهم است. توهمات هوش مصنوعی یک مشکل جدی است که باید به روشی ایمن و پایدار حل شود. مهم است که به طور مداوم روی توسعه ایدههای نوآورانه برای شناسایی و حلوفصل توهمات احتمالی در مراحل اولیه و شاید حتی پیشگیری از آنها در آینده کار شود. بنابراین شناخت خطرات توهمات هوش مصنوعی به منظور تقویت اعتماد به فناوریهای هوش مصنوعی و ترویج کاربرد گستردهتر آنها ضروری است.

نظرات